LLaMA 모델은 Facebook AI Research에서 개발한 자연어 처리를 위한 라이브러리이다. 이 라이브러리는 GPT-3의 표준을 능가하는 수준이지만 크기는 작은 장점이 있다. 다양한 자연어 처리 작업에 대한 데이터셋과 모델을 제공하기에 텍스트 분류, 질문 응답, 기계 번역, 요약 등의 작업을 수행할 수 있는데, 현재는 특허가 있는 관계로 상업용으로는 사용이 되지 않기에 학습용으로만 사용 가능하다.

LLaMA는 PyTorch와 Hugging Face Transformers를 기반으로 구성되어 있습니다. llama의 자세한 내용은 GitHub llama 페이지에서도 확인하실 수 있다.

LLaMA git 소스 다운로드 방법

다운로드는 해당 zip파일을 내려 받는 방법도 있고 몇 가지 방법이 있는데, VS Code를 사용한다면 다음의 git clone 명령으로 쉽게 내려 받으실 수 있다.

git clone https://github.com/facebookresearch/llama.git

LLaMA 패키지 설치 방법

패키지를 설치하는 방법은 requirements.txt로 설치가 가능하다.

pip install -r requirements.txtrequirements.txt를 설치하면 다음의 패키지들이 설치가 된다.

Successfully installed MarkupSafe-2.1.2 cmake-3.26.3 fairscale-0.4.13 filelock-3.12.0 fire-0.5.0 jinja2-3.1.2 lit-16.0.3 mpmath-1.3.0 networkx-3.1 numpy-1.24.3 nvidia-cublas-cu11-11.10.3.66 nvidia-cuda-cupti-cu11-11.7.101 nvidia-cuda-nvrtc-cu11-11.7.99 nvidia-cuda-runtime-cu11-11.7.99 nvidia-cudnn-cu11-8.5.0.96 nvidia-cufft-cu11-10.9.0.58 nvidia-curand-cu11-10.2.10.91 nvidia-cusolver-cu11-11.4.0.1 nvidia-cusparse-cu11-11.7.4.91 nvidia-nccl-cu11-2.14.3 nvidia-nvtx-cu11-11.7.91 sentencepiece-0.1.99 sympy-1.12 termcolor-2.3.0 torch-2.0.1 triton-2.0.0 typing-extensions-4.5.0

이번에는 조금 더 쉽게 바로 설치가 가능한, dalai llama로 설치하는 방법도 있어 그 방법을 알아보자.

Linux 환경(Ubuntu) dalai LLamA 설치 방법

사전 준비 사항

1. 메모리 요구 사항

컴퓨터 메모리 사양이 최소 4GB는 되어야 사용이 가능하다.

- 7B => ~4GB

- 13B => ~8GB

- 30B => ~16GB

- 65B => ~32GB

2. 디스트 저장 공간

모델 저장을 위한 최소한의 저장 공간이 필요하다. 설치시 옵션으로 그 크기를 정할 수 있는데, 7B, 13B, 30B, 65B 중 하나여야 한다. 설치 예제에서는 학습 테스트를 목적으로 하기에 7B로 선택한다.

| 저장 크기 옵션 | 용량 제한 (전체 / 양자) |

| 7B | 31.17GB / 4.21GB |

| 13B | 60.21GB / 8.14GB |

| 30B | 150.48GB / 5.09GB * 4 = 20.36GB |

| 65B | 432.64GB / 5.11GB * 8 = 40.88GB |

Ubuntu LLaMA 설치

Ubuntu에서 LLaMA를 설치에 앞서 두 가지 패키지가 먼저 설치되어야 실제 LLaMA 모델 설치가 가능하다.

1. 파이썬 3.10 버전 이상 설치

2. Node.js 18 버전 이상

3. LLaMA 모델 설치

예제에서는 7B 옵션의 최저 메모리 (4GB)와 저장공간으로 npx 명령으로 설치를 한다. 본인 PC의 사양이 높다면 상위 옵션으로 선택해서 설치도 가능하다.

npx dalai llama install 7B

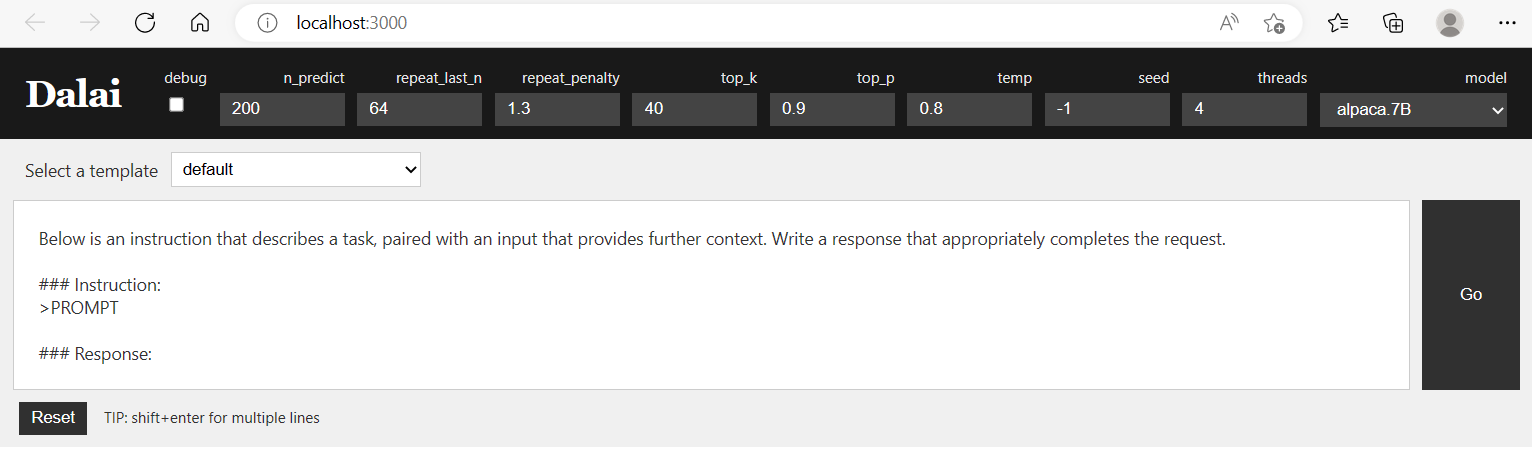

Dalai LLaMA Web UI 실행 방법

설치가 완료 되었다면, VS Code의 Prompt 또는 PowerShell command창에서 다음 명령을 실행한다.

npx dalai serve

http://localhost:3000/ 를 클릭하면, Web UI가 실행되어 학습 용도로 AI 테스트가 가능하다. 참고로 teplate는 기본(default), 번역, 챗봇, rewirte, ai-dialog, tweet-sentiment등의 template를 선택해서 실행할 수 있다.

이 블로그의 다른 글 보기

'AI' 카테고리의 다른 글

| 딥엘 번역기 사용법: 정확하고 독보적인 AI 번역 서비스 (0) | 2023.05.18 |

|---|---|

| 구글 바드 Bard 코딩 활용 방법 (0) | 2023.05.16 |

| AI 최강자 챗GPT vs LLaMA (0) | 2023.05.11 |

| AutoGPT 요금 폭탄 유의 사항 (0) | 2023.05.05 |

| AutoGPT 다운로드 설치 및 사용법 (1) | 2023.05.04 |

댓글